Muy interesante artículo publicado por la revista Nature donde discute el uso de redes neuronales y los riesgos que estas suponen, máxime cuando lo usamos en cosas tan delicadas como coches autónomos y otros herramientas con vidas humanas en juego.

Why deep-learning AIs are so easy to fool

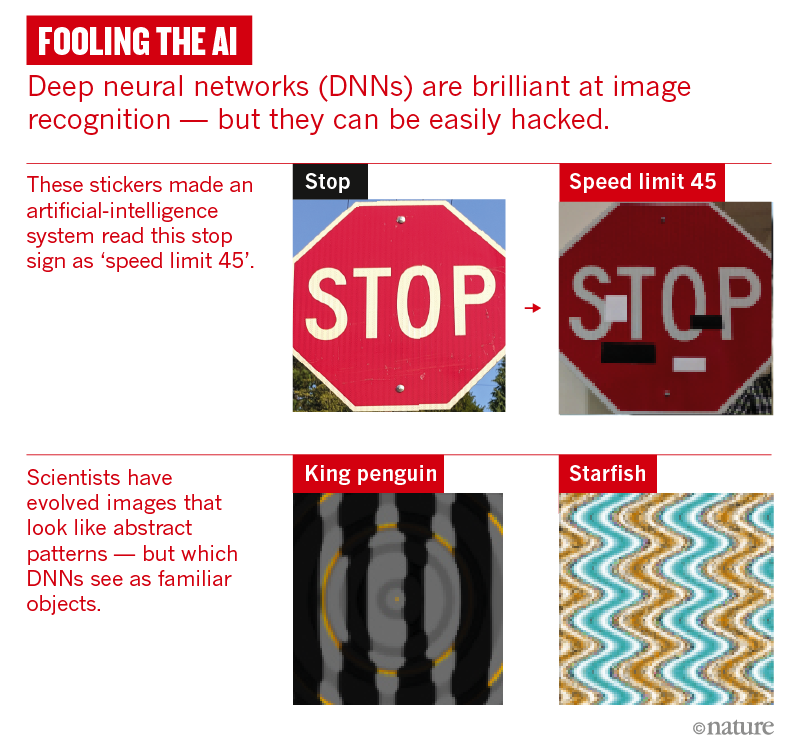

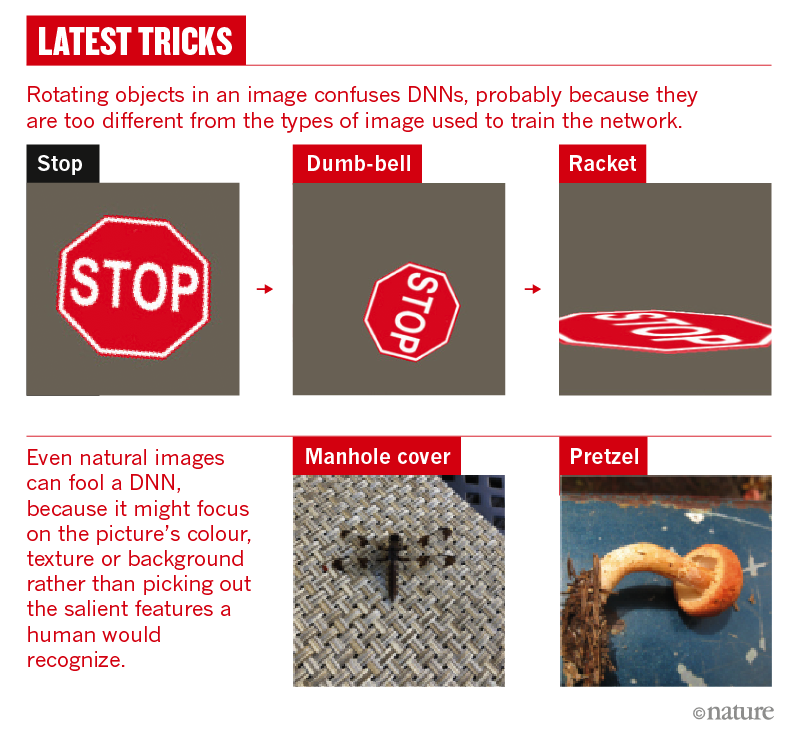

A lo largo del artículo discute sobre este asunto poniendo numerosos ejemplos de estudios y otras publicaciones que han conseguido "manipular" el comportamiento de una red neuronal introduciendo pequeñísimos cambios en la imagen que estos procesan. Por ejemplo, añadiendo 2 simples líneas con cinta aislante, puede confundir a un coche autónomo de interpretar un STOP como una señal de límite de velocidad 45, con el evidente riesgo para la circulación que esto representa:

El artículo pone de manifiesto el riesgo que supone la creciente euforia en el uso de las CNN que nos puede llevar a precipitarnos en su implementación en el día a día y particularmente en poner nuestras vidas o intereses a su servicio.

Nadie discute que las redes neuronales formarán parte muy relevante en nuestras vidas futuras, pero también hay que ser conscientes de que son técnicas nuevas que están aun bajo desarrollo y de las que a veces no conocemos tanto como creemos sobre su funcionamiento.

Me ha parecido muy interesante.