Analizando las nuevas gráficas q hay en el mercado, tanto en rendimiento y precios, estoy casi al 100% seguro de q la mejor tarjeta del mundo será la 6800XT, xq lo tiene todo y me explico.

Reúne el mayor abanico de compradores ya q aparte de su potencial, los 16GB de Vram le dan mucha vida útil ya q nunca se quedara corta de aquí a minimo 5 años, en cambio la 3080 si q podría tener algún q otro problema. La inversión esta justificadisima incluso para pobres como yo ya q tendrias grafica para muuuuucho tiempo.

La clave de esta gráfica esta en su binomio precio/Vram

#720 El strobe es otra farsa, y el DLSS ni lo he utilizado, pero no dudo de sus beneficios.

Yo veo el DLSS (2.0 no los anteriores que eran sida) como un apaño para acompañar el Ray Tracing cuando tu GPU no da para más y te pegan bajadas sub 60 fps. Ahí activas el DLSS en modo quality y compensas algún que otro fallo y/o artefacto con tener RTX.

Pero hay un trecho de eso, a llegar al nivel del subreddit de Nvidia, donde la gente defiende el DLSS diciendo que se ve mejor que la resolución nativa y aún por encima más FPS xDDD

Personalmente, como solo me interesa jugar a 1440p y viendo el rendimiento de las GPUs nuevas, creo que me la va a sudar bastamente el DLSS o lo que sea que AMD saque.

A mi hay solo dos cosas que me hacen dudar, RTX Voice y el encoder de nvidia, amd no tiene nada parecido (ni lo va a tener) y es algo que tiene bastante peso en mi decisión. Si buscara solo rendimiento... la mayoría de juegos que usaré tiraran de raster y ahí la 6800XT parece la mejor opción sin duda (a 1440p144)

#722 si y no, yo no diría que se ve mal, simplemente diría que tiene defectos que según tu conocimiento de la tecnología o de como de sensible seas a los gráficos y detalles pues puedes fijarte o no. Yo lo he probado en algunos juegos ( metro y FF) y personalmente me gusta cuando juego con el portátil ya que es una 2060 y se nota mucho en el framerate, pero para alguien que quiera gráficos entusiastas no creo que sea. Pero vamos seguro que no diría que hay una diferencia obvia.

#726Frave:personalmente me gusta cuando juego con el portátil ya que es una 2060 y se nota mucho en el framerate, pero para alguien que quiera gráficos entusiastas no creo que sea.

Bueno claro coño, obviamente no es una solucion para usar siempre. Ya digo, a mi no me ha hecho falta nunca todavía.

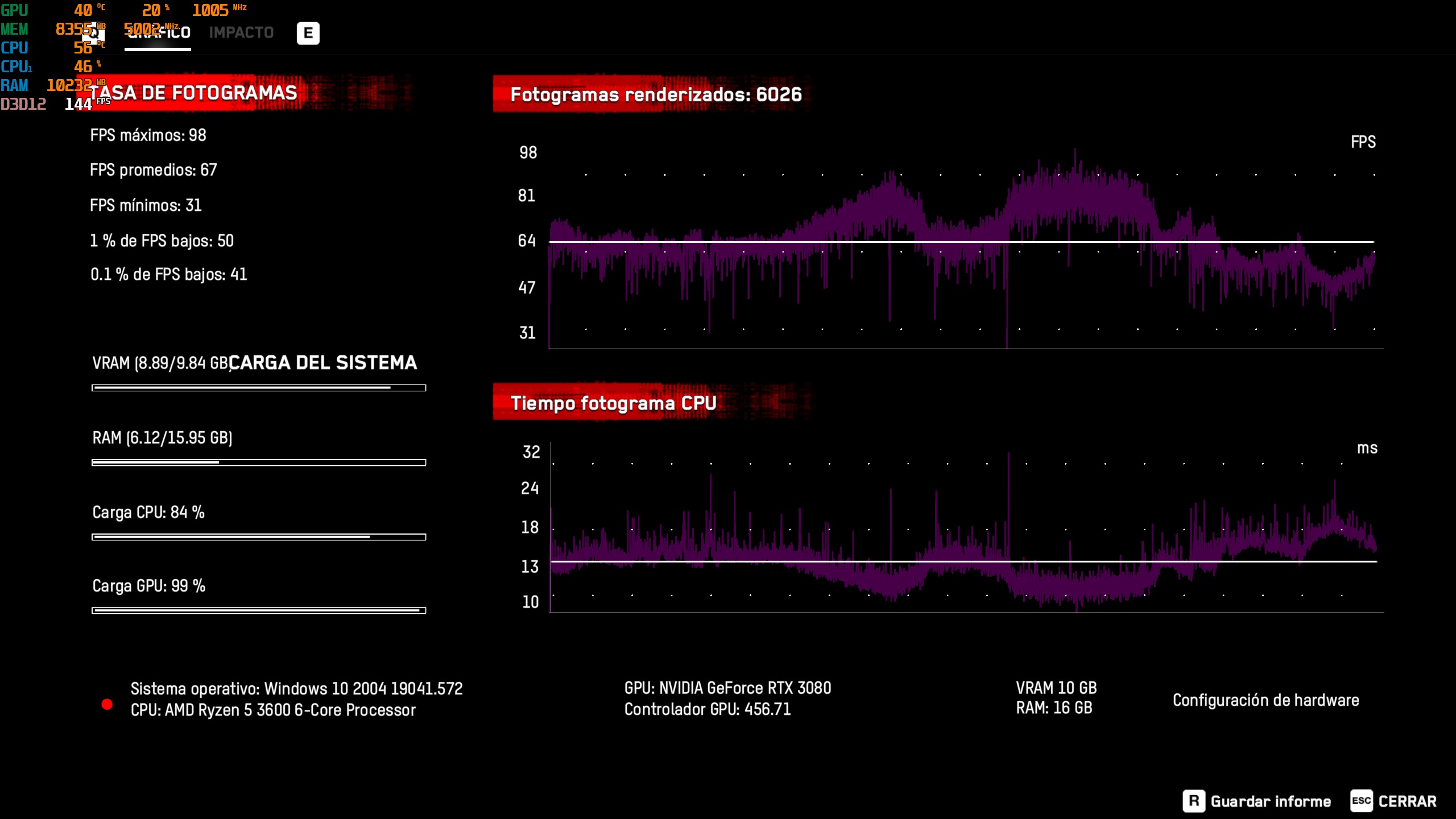

Viendo el rendimiento de la 3080 del compañero @Leu cuando pones a la venta la 6800??

#4222Leu:A ver el ray tracing es la leche y se nota un huevo, de hecho flipo con reflejos y iluminación, pero el juego va entre los 50 y los 60 siempre, de ahí no sube.

Por no decir que consumo de VRAM es de 9,5 GB constantes, y acabo de empezar el juego...

#4224Leu:bueno... jugando y metiéndome por el centro de la ciudad con coches y la cosa mas chunguilla el juego baja incluso a 35 FPS consumiendo casi los 10GB de VRAM

aixxx que estos 10GB se nos han quedado cortos ya... y eso que con este juego se promociona NVIDIA, me caxis... mala jugada ehAhora me entra la duda de como funcionará cyberpunk entonces.

Watch dogs no es que tenga super gráficos increíbles, y funciona así... probablemente sea optimización si no no lo entiendo.

Resolución: 1440p

#725 Y sobre encoders, me extraña que AMD no tenga alternativa a nvenc , porque para streaming es importante. Y no se que parte habrá del pastel de gente que juega y hace stream a la vez, pero no será poca.

#728 Ese juego esta tarado, si aparte con DLSS y RT va a 60 fps, no quiero saber como irá en el resto xD

#727 no tienes que tomarte todo como un ataque eh que solo estaba dando mi opinión y dándote la razón ademas xD

#730 No no, no me lo tome como un ataque XD Sorry si sono asi, simplemente queria aclarar que tambien lo veo util en escenarios concretos, no para usarlo siempre y tal.

Yo el fallo mas típico que veo en DLSS son los errores en texturas estáticas con cierto relieve o en detalles fino como el pelo o lineas rectas de pocos pixeles. Ya comente hace tiempo este fallo en otro hilo, lo veo siempre en los juegos con DLSS, pero claro son cosas concretas que tienes que saber que están ahí para fijarte en ellas.

por ejemplo la camiseta en el 1:05 de este vídeo.

#733 mm no se en el metro lo he visto también y no se si usa 2.0 y en las ultimas versiones del DLSS del FF sigue ocurriendo también. Igual en juegos mas recientes ya han conseguido evitar que bailen ciertas texturas.

Cuando la gente se entere de que el RT es un parchazo encima del juego y que no se desarrollan pensando en eso les explota la cabeza. Quedan AÑOS para que el RT sea algo de facto en los juegos. A día de hoy es como PhysX en sus inicios: un gimmick que te manda el rendimiento a la puta.

#734 Hay cosas que siguen ahi, pero busca el video comparativa de DF por ejemplo del nuevo DLSS en Control.

#735 hasta que las gamas bajas no muevan RT de una manera decente seguirá siendo un parche, quedan al menos un par de generaciones para eso

me voy a comprar una nvidia porque no se usar una puerta de ruido vst de 125kb en el obs vamos para allá amd estás LITERALMENTE muerta

pd: l anvidia tira rayos bro y la amd que tira? SUSHI? HAHAHA

pd2: esta pa jen sun juan https://github.com/alexjc/neural-enhance

yo debo ser de esos ciegos que no veo nada pero a mi el control con DLSS me parecio que se veía incluso mejor que en nativo. Debo estar ciego pero yo por lo menos lo veía cojonudo. Ahora que si paras la imagen la amplias 10x y le ves no se que... pues sinceramente me importa un rábano

De

#95ArThoiD:Pillo decepción

y

#248ArThoiD:Ahora falta que la pongan a 600€ y bye Nvidia, pero todos sabemos que serán 800 como minimo.

#258ArThoiD:No van a enseñar comparaciones de RT.... Obviamente ni sea acercan a Ampere

a

#303ArThoiD:Ostiassssssssssssssss

#369ArThoiD:Sacadisima lol

Me he reído xD

#743 Al final visto en frio... Fue un poco decepcionante tbh.

Precio oficial solo 50$ más barata, veremos si realmente en rendimiento iguala a la 3080, y la 6800 más cara que la 3070...

#745 ¿Igual están respondiendo a la 3070 TI que está a punto de caer? Y lo de los 70€ veremos a ver, porque una cosa es la diferencia en precios oficiales frente a los precios en tienda.

De todos modos la 6800 seguro que le saca un 10% a la 3070 y tiene el doble de vram. Si los drivers no hacen aguas la diferencia de precio lo vale.

Lo que sí que veo muchos huecos en el lineup de AMD. Entre la 5700XT y la 6800 hay un huevo y medio de espacio en blanco. Deberían anunciar también la 6700XT (que será la que compita con la 3070), 6700, etc.

De todos modos simplemente por la 6900XT que andará no muy lejos de la RTX3090 por $500 menos pues... ha sacado más de lo que se esperaba, imo. Yo asumí hace tiempo que por cojones competirían de tú a tú con la 3080, pero lo de la 6900XT no me lo esperaba.