La PS4 monta una cpu JAGUAR que ya el día de lanzamiento rendía menos de la mitad que cualquier cpu de pc. PS5 y las nuevas Xbox sí llevan una cpu actual y acorde a lo que se monta en pc. No hay comparación posible.

Por eso dije que importa mucho más la potencia por núcleo que el número de núcleos, por eso mismo que señalas. En unos meses cuando estén las consolas llegando a los usuarios a ver qué desempeño tienen los últimos ryzen y la respuesta de intel, me gustaría ver cómo rinden estas nuevas consolas con juegos cpu dependientes donde el ipc alto es la clave, luego se dirá que los juegos están "mal optimizados", curiosamente suelen ser juegos de mundo abierto, gran cantidad de ia, npc, información constantemente cargando del servidor al cliente en el caso de ser multijugador, es decir, la mayoría de juegos triple AAA que están por venir, los más vendidos serán así.

Ahora, hay que recordar una cosa, la 2080 tiene 8gb, la 3080 tiene 10gb, la 2080 ti tiene 11, ¿la 3080 ti unos 12 o 14, quizás? La cosa no es tanto que nvidia se haya quedado corta en vram, es que AMD ha querido presentarse por todo lo alto con mucha más vram, al igual que los ryzen fueron un gran reclamo por su cantidad de núcleos, co las primeras series sin dar vergúenza ajena con la potencia por núcleo a pesar de no llegar a intel, y sobre todo con precios competitivos dando cpus de hasta 8/16 muy asequibles, y a mí eso me parece bien, gracias a eso pude pillar un intel de 6/12 como el 8700k, por 400 euros, en vez de otro refrito similar al 7700k de 4/8.

Para mí la vram se te puede quedar corta si vas a usar varios monitores a 2k, en el caso de una 3070, no con una 3080, y puede que en unos años, al igual que pasaba con la 1080, para eso está la TI. Y yo no soy tampoco un fanboy de nvidia, de hecho pienso que la 6090 si vale 1000-1100 euros es la que habría que pensar en pillar para alguien que tiene varios monitores 2k para juegos en simuladores de coches, aviones etc, esa gráfica para ese presupuesto es más lógica, la 3090 muere por el precio, sin más.

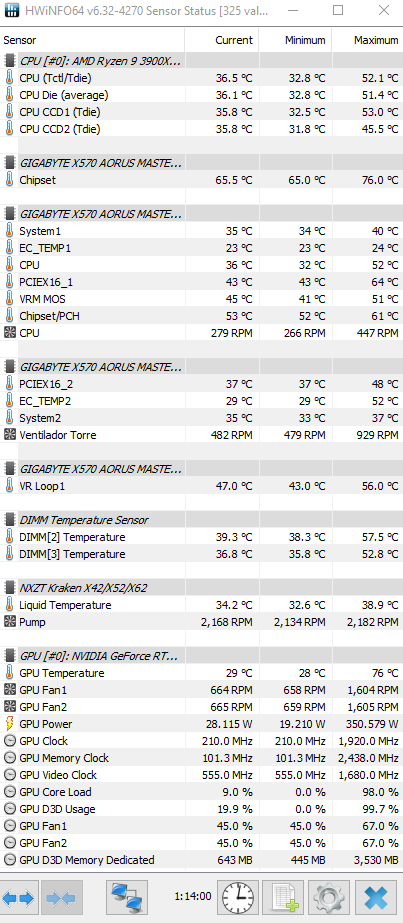

Ahora, para jugar en un solo monitor 1080p, 2k 144hz, y 4k 60fps, la 3080 va sobrada ahora, y dentro de los próximos años. Y puedo hablar de esa gráfica porque la tengo, ni idea de la 3070, la 3060 o las de AMD cuando empiecen a llegar con suerte a lo largo del año que viene se sabrá.

de sobra. aunque mi 8700k me preocupa mas

Yo tengo el 8700k a 4.8 1240v y ya he probado un buen puñado de juegos con la 3080, y no creo que cambie de procesador en 2 años como mínimo, a no ser que vea un procesador que saque más de un 25% en ipc.